【KDDI総合研究所】「音場のインタラクティブ合成技術」を開発。仮想空間で「音」の立体表現が可能に

近年、どんどん進化しているメタバース。

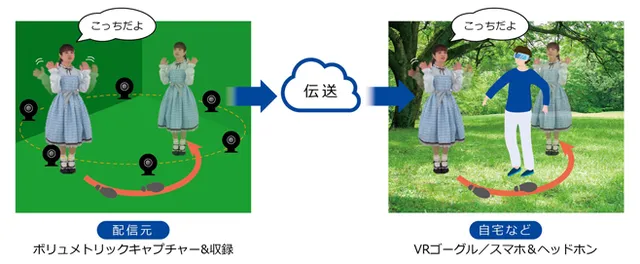

特に、モーションキャプチャーやボリュメトリックキャプチャーなどの技術により、3D物体の動きや見た目を仮想空間上でリアルに再現できるようになってきた。

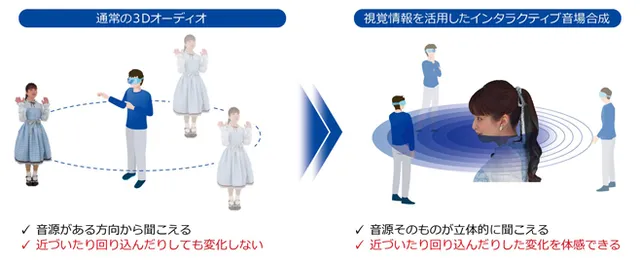

その一方、音については改善すべき課題があるようだ。

というのは、仮想世界で3D物体を好きな向きや位置から見られるようになってきているにもかかわらず、音の発生源は一定なんだそう。

そこで、「KDDI総合研究所」は「音場のインタラクティブ合成技術」を開発。なんでも、仮想空間上にいても現実世界と同じように音が聞こえるようになるらしい。

©KDDI総合研究所

この技術は、3D物体の向きや動きなどに応じて音場をリアルタイムで合成するとのこと。アバターの動きと音が連動することで視覚と聴覚の両方で空間認知ができ、仮想世界にいながらリアルなコミュニケーションがとれるようになるという。

仮想空間で音が立体的に聞こえるようになれば、メタバースの可能性はさらに広がるだろう。例えば、アーティストが臨場感のあるライブを開催できるようになるかもしれない。

©KDDI総合研究所

同社は今後、音の反射や反響特性なども反映できるように技術を発展させていくとのこと。

「KDDI総合研究所」が起こそうとしているイノベーションから、目が離せない——。

Reference: 3D物体の音を立体表現する、音場のインタラクティブ合成技術を開発

Top image: © Jackie Niam/Shutterstock.com