MITならではの「料理ハック」。材料とレシピを料理写真から予測する。

SNSなんかで流れてくる、友達の“手づくり料理自慢”。どうやって作ったんだろうと気になってしまったり。あるいは、予約の取れないあの店のあの料理、写真だけで味わってきたけれど…。

でも、それが一瞬でわかっちゃうとしたら?

料理写真から

原材料とレシピを予測

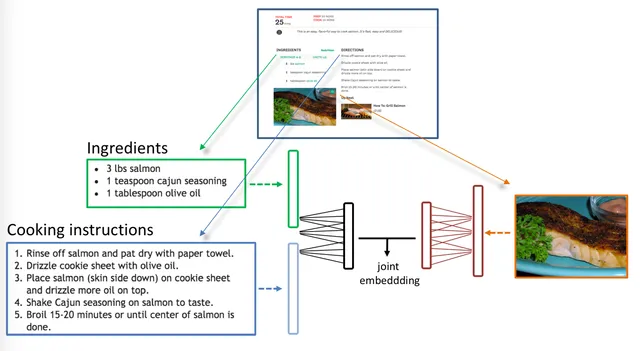

アメリカMITのComputer Science and Artificial Intelligence Laboratory (CSAIL)の研究者たちが開発しているのは、そんな時代に沿った画期的な新システム。

なんでも料理の写真を提示するだけで、その原材料とレシピを割り出してくれるんだとか。「これ美味しい!」を「自分でも作ってみよう!」の発想に変えてくれるわけだから、このアイデアが料理づくりへのハードルを少しだけ下げてくれたと言えるんじゃないでしょうか。

あ、もちろん調理のスキルは別のハナシですけどね。

まずは料理の写真をパシャリ

まずは、気になる料理の写真を撮ります。すると、独自のアルゴリズムを使って、MITが作成したデータベースの中から類似する料理を検索。写真とできるだけ近い料理の原材料と、レシピを探してきてくれます。

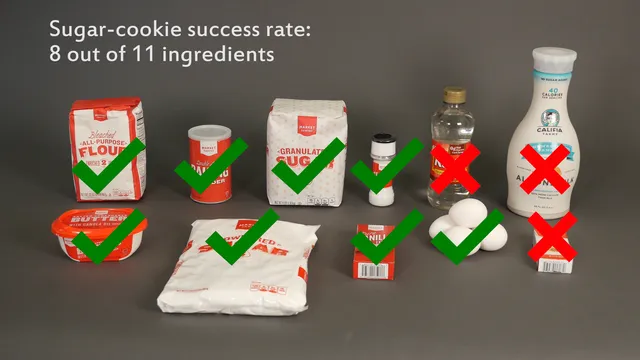

現段階での精度は、まだまだ科学者たちを納得するまでとはいかないようですが、近い将来、その整合性は80%近くまで上がってくるだろうと、自信を覗かせています。

アイデアソースは、

100万種以上の料理データベース

今のところ、香港大学が110,000の画像と65,000のレシピを揃えた同様のシステムを構築していますが、クリエイトできるのは、残念ながら「中国料理」のみ。MITの狙いは、これをはるかに上回る100万種類以上の料理データベースの構築。実現すれば、日本の料理からも、きっといくつかデータベース化されるはず。

オンラインで試せます

誰でもオンラインでデモ版を試せるので、今の精度を試してみると面白いかも。ちなみに、現段階ではクッキーやマフィンなどのデザートものに強いようです。反対に、巻き寿司やスムージーなど中に何が入っているか一見わからないものには弱いそう。

いつか、こういうシステムがSNSでもデフォルトで使用できる時代がくるんだろうなあ。